Kan robotar lära sig att planera sitt eget arbete för att lösa komplexa uppgifter?

Forskare på Chalmers har utvecklat en AI som genom att iaktta mänskligt beteende kan anpassa sig och utföra uppgifter i en föränderlig miljö.

Sådana flexibla robotar kan i mycket högre grad arbeta tillsammans med människor.

− Robotar som arbetar i mänskliga miljöer behöver ta hänsyn till att vi människor är unika och att vi löser samma uppgift på individuella sätt. Därför är ett viktigt område inom robotutveckling att lära robotar att arbeta nära människor i dynamiska miljöer, säger Maximilian Diehl, doktorand vid institutionen för elektroteknik och ledande forskare bakom projektet.

− Robotar som arbetar i mänskliga miljöer behöver ta hänsyn till att vi människor är unika och att vi löser samma uppgift på individuella sätt. Därför är ett viktigt område inom robotutveckling att lära robotar att arbeta nära människor i dynamiska miljöer, säger Maximilian Diehl, doktorand vid institutionen för elektroteknik och ledande forskare bakom projektet.

När vi människor utför en enkel uppgift, som att duka ett bord, kan vi agera på flera olika sätt beroende på hur förutsättningarna ser ut. Om en stol oväntat står i vägen flyttar vi på den eller går en omväg, vi använder omväxlande höger eller vänster hand, gör pauser eller har andra oplanerade beteenden.

Robotar fungerar inte på samma sätt. De behöver exakt programmering hela vägen mot målet. Det innebär att de arbetar effektivt i miljöer där de hela tiden följer samma mönster, som i en fabrik. Men för att interagera tillsammans med människor inom exempelvis service eller sjukvård, krävs att robotarna utvecklar ett mycket mer flexibelt beteende.

Lärde roboten att bygga torn trots varierande förutsättningar

Forskarna ville undersöka om de gick att lära en robot att i högre utsträckning lösa uppgifter på samma sätt som människor. Alltså att skapa en förklarande AI som utvinner övergripande istället för specifik information vid en demonstration, för att sedan kunna planera en flexibel väg mot ett långsiktigt mål. Förklarande AI (Explainable AI eller XAI) är en metod som kan beskriva för människor hur en AI-algoritm fattar ett visst beslut.

De lät människor utföra samma uppgift – att stapla kuber på varandra – tolv gånger i en VR-miljö. Varje gång utfördes uppgiften på olika sätt och människornas rörelser registrerades med hjälp av lasersensorer.

− När vi människor har en uppgift delar vi upp den i en kedja av mindre mål på vägen, och varje handling vi utför syftar till att uppfylla ett sådant delmål. Istället för att lära roboten en exakt imitation av mänskligt beteende fokuserade vi på vad målet var med alla de handlingar som människorna i studien utförde, säger Karinne Ramirez-Amaro, forskarassistent på institutionen för elektroteknik.

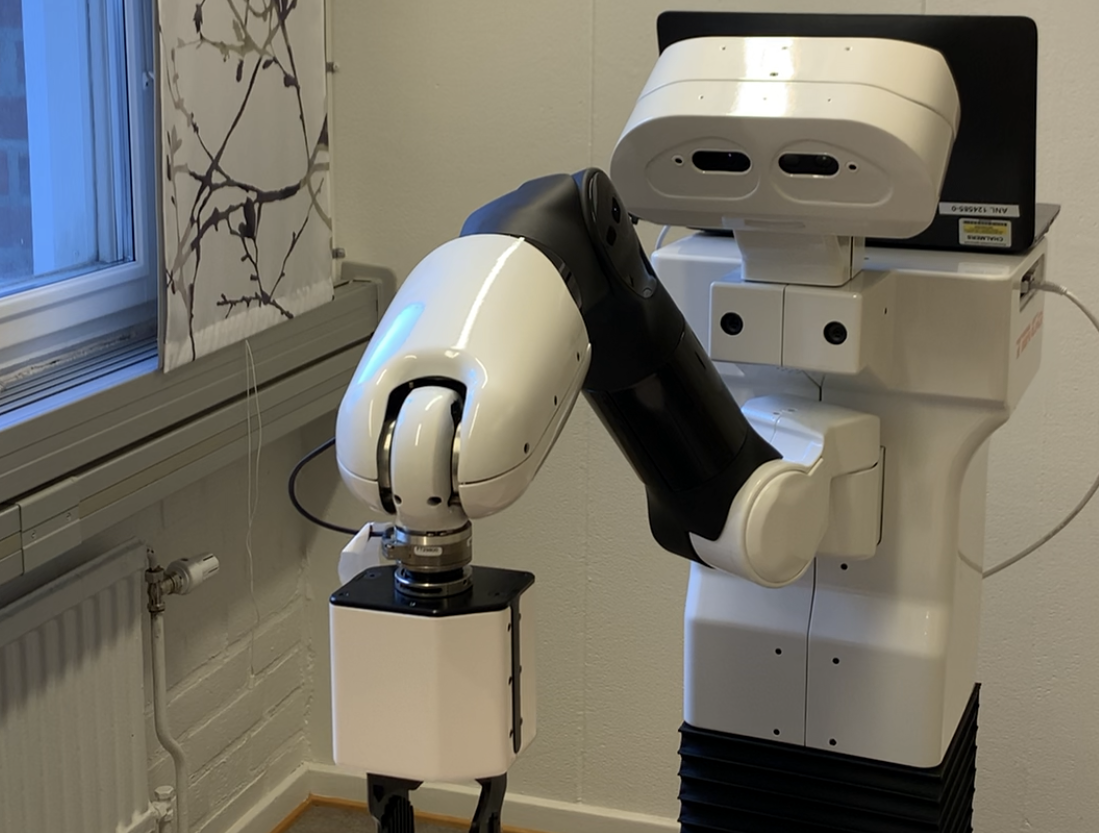

Forskarnas unika metod gick ut på att systemet extraherade meningen med delmålen, och byggde bibliotek bestående av olika handlingar för varje delmål. Slutligen skapade systemet en AI i form av ett planeringsverktyg som användes av en TIAGo-robot, som är designad för att arbeta i inomhusmiljöer, med en utdragbar torso och en arm som kan gripa och flytta föremål. Med hjälp av verktyget kunde roboten automatiskt skapa en plan för att stapla kuber på varandra även när omgivningens förutsättningar förändrades. Kort sagt: Roboten fick i uppgift att stapla kuber och valde sedan själv bland flera möjliga handlingar den sekvens som, efter omständigheterna, ledde till att uppgiften utfördes. Roboten klarade alltså att själv planera hur den skulle göra för att lyckas stapla kuberna trots att förutsättningarna förändrades lite vid varje försök.

− Resultaten visade att vår metod kan skapa planer som utförs korrekt till 92 procent efter en enda mänsklig demonstration, och hela 100 procent korrekt när informationen från alla tolv demonstrationer användes, säger Maximilian Diehl.

Chalmersforskarnas studie presenterades på IROS 2021, en av de största och mest inflytelserika konferenserna om intelligenta robotar och system. Nästa studie i forskningsprojektet, som nu är i sitt slutskede, undersöker hur robotar kan kommunicera med människor, och förklara vad som gått fel och varför, om de inte lyckas utföra en uppgift.

− Helt autonoma och flexibla robotar för exempelvis sjukvård och serviceyrken ligger fortfarande flera år framåt i tiden. Utmaningarna ligger främst inom datorseende, kontroll och säker interaktion med människor. Men vi tror att vår metod kommer att bidra till att snabba på lärandeprocessen för robotar, så att de kan ta in alla de aspekterna och tillämpa dem i nya situationer, säger Maximilian Diehl.

Forskningen utfördes tillsammans med Chris Paxton, forskare på NVIDIA, med finansiering från Chalmers AI Research Centre (CHAIR).